728x90

Perceptron

- 입력 (x)에 대해 가중합 (z = w^Tx+b)을 만들고, 임계함수로 이진 분류 (y=1[z>0]) 하는 것.

- 선형 분리 가능 문제 (AND, OR gate) 표현 가능.

- 한계점: 결정 경계가 직선/초평면 하나라서 XOR과 같은 비선형 분리 문제 표현 불가.

Multi Layer Perceptron (MLP)

- 위 문제를 극복하기 위해, 은닉층을 추가하고 각 층마다 비선형 활성화 (\sigma (\cdot))를 사용.

- 즉, MLP = 여러 Fully Connected layer + 활성화 함수로 쌓은 구조.

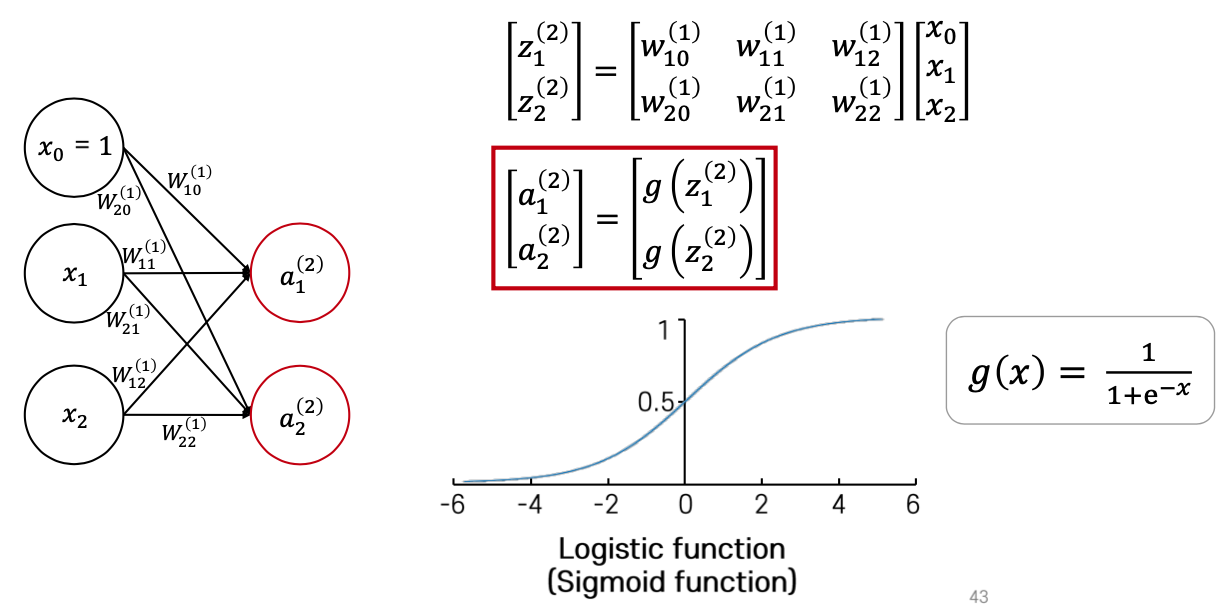

Fully-Connected Layer

- 입력층의 모든 노드가 출력층의 모든 노드와 연결된 선형 변환.

- Linear Layer 라고도 부름.

- MLP는 이 FC layer를 쌓아서 만들었다 보면 됨.

Forward Propagation

Weight Matrix: i 번째 layer와 i+1 번째 layer를 연결하는 가중치 행렬.

Activation: 비선형 함수 (sigmoid, tanh, ReLU 등)를 적용해 출력의 비선형 변환을 만든 것.

- i+1번째 layer의 뉴런에 전파하기 전에 어떤 뉴런을 on/off할지 본다고 봐도 됨.

- i+1번째 layer의 뉴런에 전파하기 전에 어떤 뉴런을 on/off할지 본다고 봐도 됨.

반응형

'[대학원] AI > Computer Vision' 카테고리의 다른 글

| HoG (Histogram of Oriented Gradients) (0) | 2025.09.11 |

|---|---|

| SIFT (Scale Invariant Feature Transform) (0) | 2025.09.11 |